本篇文章4200字,读完约11分钟

如果你想了解机器学习,或者已经决定加入机器学习,你会在第一时间找到各种收费的教材,同时,你会默许你的心:这本书是关于牛的终身智慧,这是一个准确的行动指南,你可以通过努力学习得到快速提高。但事实是,你可能已经绕道了。

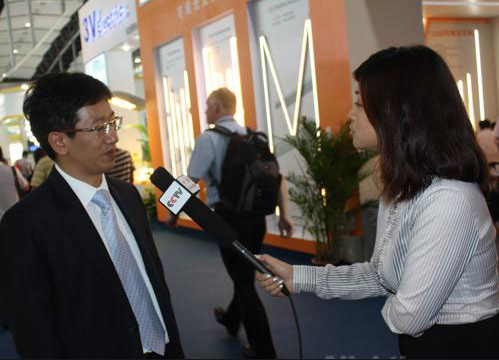

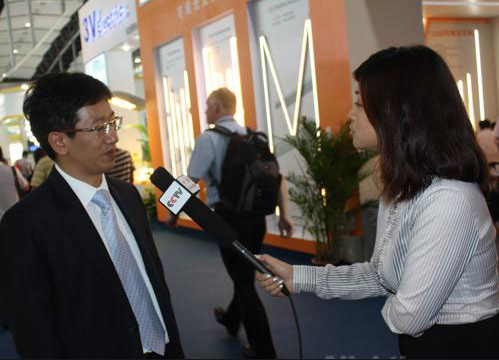

随着科学技术的飞速发展,数据呈指数级增长,环境也呈指数级变化,因此教科书往往跟不上时代的发展。有时,即使是那些写教科书的人也不一定理解结论背后的“为什么”,所以有些结论会落后于时代。为了解决这个问题,第四范式的创始人兼首席执行官戴文渊最近在公司内部共享的机器学习教科书中引入了七个经典问题。戴文渊是acm (2005)的世界冠军,也是“迁移学习”的全球领导者,在迁移学习领域,一篇论文的引用次数仍然位居世界第三。他曾是百度封超战略的技术总监和华为诺亚方舟实验室的首席科学家。这篇文章是根据演讲记录整理出来的,但略有删节。

有时我们会发现实际工作中应该做的与教科书中的结论相矛盾。此时应该做什么?教科书中的结论是错误的吗?事实上,有时的确如此。所以今天,我想和大家分享一些机器学习课本中的经典问题,希望能对大家今后的工作和学习有所帮助。

问题一:神经网络不应超过三层,这是最著名误判。目前的教科书几乎不再有这样的结论,但如果你看看15或20年前的机器学习教科书,你会有一个非常有趣的结论:神经网络不能超过三层。这与我们现在谈论的深入学习是矛盾的。在深度学习中,不是神经网络是否能超过三层,而是它能否达到一百层、一千层或更多。

那为什么以前的教科书说神经网络不能超过三层?有必要从神经网络的历史开始。20世纪50年代,一位名叫马文·明克斯的科学家是一位擅长数学的生物学家。因此,当他研究神经元时,他想知道是否可以用数学模型来描述生物神经元,所以他设计了一个感知器。感知器就像一个神经细胞,可以像神经细胞一样连接起来形成一个神经网络,就像大脑的神经网络一样。事实上,在20世纪60年代初,有一个很深的神经网络,但是经过大量的实验,发现不超过三层的神经网络工作得很好,所以在20世纪80年代得出结论,神经网络不应该超过三层。

那么为什么这个结论现在被推翻了呢?事实上,这一结论有一个前提条件,即当数据量不大时,神经网络不应超过三层。自2005年以来,人们发现随着数据的增加,深层神经网络表现良好,因此它逐渐向深度学习发展。事实上,这里真正正确的原则是维拉提莱玛,它可以理解为“模型的复杂性(如专家系统的规则数)与数据量成正比。”数据量越大,模型就越复杂。在上个世纪,由于数据量小,神经网络的数量不应该太多。现在,由于数据量很大,神经网络的数量应该很深。这也解释了为什么当时教科书得出这个结论,但是现在随着深度学习的普及,人们不再认为这句话是正确的。

问题2:决策树不能超过五个级别。如果一些学生阅读教科书中介绍的决策树,就会有一种说法,决策树应该被修剪。如果决策树不修剪,效果就不好。有些教科书告诉决策树不能超过五个层次,超过五个层次的决策树是无效的。这一结论与神经网络的结论相同。神经网络不能超过三层,因为当时的数据量不大;决策树不能超过五层,因为上个世纪的数据量不够大。如果二叉树决策树的深度为n,复杂度约为2的n次方,所以不超过5层的复杂度大于30。如果数据量达到一百万,决策树可以达到十层或二十层的规模,如果数据量达到一百亿,决策树可以达到三十层。

现在,我们强调更深层次的决策树,这可能与教科书相矛盾。产生矛盾的原因是整个场景中的数据量变大了,所以应该做一个更深的决策树。当然,我们不一定在所有场景中都有大量的数据。如果我们遇到有少量数据的场景,我们也应该知道决策树应该是浅的。基本上,这取决于有多少数据以及一个模型可以写得有多复杂。

问题3:特征选择不能超过1000。一些教科书会单独开一章讨论特征选择,告诉我们在获得数据后删除一些不重要的特征。一些教科书甚至指出特征的数量不能超过1000个,否则该模型是无效的。但事实上,这个结论是有前提条件的。如果数据量很小,许多特性不能得到完全支持,但是如果数据量很大,结论就会不同。这就是为什么当我们进行物流配送时会有数十亿个特征,而不是局限于数百个特征。

过去,传统的数据分析软件,如sas,只有几百个功能,因为它诞生于20世纪70年代。它面临的问题是,在特定情况下没有多少可用数据,可能只有数百或数千个样本。因此,当设计一个系统时,它只需要设计数百个特征,而不是数十亿个特征,因为数千个样本不能支持数十亿个特征。但是现在,随着数据量的增加,特征量也需要增加。因此,我认为在大数据环境下,整个机器学习教材中关于特征选择的章节已经落后于时代,需要根据新的形式进行改写;当然,在小数据场景中,它仍然有价值。

问题4:综合学习达到最佳学习效果。第四种叫做综合学习。这项技术在各种数据挖掘竞赛中特别有用。例如,近年来,几乎所有的kdd杯冠军都采用了综合学习。什么是综合学习?不是制造一个模型,而是制造许多(例如,一千个)不同的模型,让每个模型投票,投票的结果就是最终的结果。如果不考虑资源限制,这种模式是最好的。这就是为什么kddcup的玩家都选择综合学习方法,他们不在乎在追求最终结果上投入多少。在这种情况下,整合学习是最好的方式。

然而,在现实中,企业在机器学习中追求的不是使用无限的资源来达到最好的结果,而是如何充分利用有限的资源来达到最好的结果。假设一个企业中只有两台机器,我们如何用这两台机器获得最佳结果?如果使用集成学习在两台机器上运行五个模型,需要将两台机器分成五个部分,每个模型只能在0.4台机器上运行,因此运行数据量是有限的。然后,用另一种方法,你可以用一个模型运行而不用集成学习,你可以运行五倍的数据。通常,5倍的数据比集成学习有更好的效果。集成学习很少在工业中应用,主要是因为工业中的大多数场景都是资源有限的,而最好的方法是在资源有限的情况下找到方法来放入更多的数据。综合学习只能放较少的数据,因为它运行更多的模型,而且这种效果通常会变得更差。

问题5:阳性样本和阴性样本以1: 1的比例均匀采样。第五种叫做平衡抽样,这将在大多数教科书中提到。这意味着如果我们训练一个模型,正样本和负样本是非常不均匀的。例如,当阳性样本与阴性样本的比例为1: 100时,必须以平衡的方式对阳性样本和阴性样本进行采样,这是最好的。但事实上,这个结论不一定正确,因为统计学习中最基本的原则是训练场景和测试场景的分布应该是相同的,所以这个结论只在一个场景中成立,也就是说,使用模型的场景中的正负样本是1:1,所以这个结论是正确的。

正确的方法是应用场景是1: 100,训练集也是1: 100。均衡采样并不总是正确的。在大多数情况下,代替取样是正确的。因为大多数情况下,我们直接随机或按时间分割训练集和测试集,这两个集合的分布是一致的。最好不要在那个时候取样。当然,有时,我们也发现做负采样会有更好的结果。例如,当范例为一个股份制银行卡中心进行反欺诈交易时,它进行负采样,因为当我们将所有样本放入时,我们发现计算资源不够,所以我们只能进行采样。阳性样本与阴性样本的比例约为1: 1000或1: 10000。如果对阳性样本进行采样,丢失的信息量会相对较大,所以我们选择对阴性样本进行采样,比如1: 1000采样,然后将权重为1000的阴性样本加回去。在资源有限的情况下这样做可以最大限度地减少信息的损失。但是仅仅为了均衡而采取负样本通常是错误的。与以前的问题不同,负采样不是环境变化的结果,所以不应该进行负采样。

问题6:交叉验证是最好的测试方法。下一个问题叫做交叉验证,这意味着如果一个数据被分成一个训练集和一个测试集,此时如何评估它的错误?交叉验证是将集合分成五个部分,将四个部分作为训练集,一个部分作为测试集,每次选择不同的部分作为测试级别,最后测量五个结果并平均,这被认为是最好的测试方法。

交叉验证确实是一种很好的验证方法,但在实际应用场景中,它通常不是最合适的方法。因为一般来说,我们用机器学习做的是预测,在大多数情况下,我们用当前或过去的数据作为模型来预测未来。然而,从过去的训练中预测未来的最好的测试方法不是交叉验证,因为交叉验证是按事务或按人划分的。最合适的方法实际上是按时间分割,例如,在评估时,选择一个时间点,用该时间点之前的数据进行训练,并在该时间点之后进行预测,这是最接近实际应用场景的评估结果。

交叉验证可能只适用于与时间属性无关的场景,例如人脸识别,但我们面临更多的应用场景,无论是风险、营销还是反欺诈,这些场景都是用过去的数据训练出来的,可以预测未来。对于这种情况,最合适的评估方法不是交叉验证,而是时间分割。

问题7:过度穿着肯定不好。最后一个被称为过度拟合,这也是一个话题,已经讨论了很多。在过去,我们通常说,如果模型太复杂,它将被过度拟合,如ppt的右侧所示,最好的方法应该是在图形的中间-拟合刚刚好,而图形左侧的模型拟合不足,这是没有充分训练。但是现在,大多数真实场景都是用过去来预测未来。过分合身不一定是坏事,但取决于具体的场景。如果在这个场景中有很多过去看到的情况和很少新的情况,过度适应是好的。

例如,如果期末考试的问题是通常的家庭作业,这是我们背诵所有通常的家庭作业的最好方法,这是不合适的。如果你期末考试没有带平时的作业,而且都是新问题,此时你不能只是背诵平时的作业,还要充分理解这门课程的知识,掌握推理和解决问题的技巧。因此,过度合身是好是坏完全取决于场景。如果应用场景可以通过死记硬背来解决,那么过度适应是好的。事实上,在我们的设计中,很多时候我们倾向于有点过于合适,我们可能在提出新问题上有点差,但是我们会在死记硬背方面做得很好。在过去被用来预测未来的应用场景中,有时过度拟合不一定是坏事,但应该根据实际情况来看待。

今天,我和大家分享了一些课本上的经典问题。事实上,在实际的工业应用中,我们不会完全遵循教科书中的方式。我们还将设计一个深度模型,一个深度决策树,许多功能,和一点点过度拟合。我们强调时间分割,而不是均衡抽样。面对教材中的结论,我们需要学习的是根据实际场景做出相应的灵活判断。

雷锋。(公开号码:雷锋。注:标题地图来自频道

雷锋的特别贡献。严禁擅自转载。详情请参考转载说明。

标题:第四范式戴文渊:机器学习教科书的 7 大经典问题

地址:http://www.hcsbodzyz.com/hcxw/10797.html